Hallo Leute,

ich habe eine praktische Frage:

wenn ich eine Datei 100.000mal bis millionen-fach kopiere (also immer KOPIEvonKOPIEvonKOPIE...)

wann treten dann erste Fehler auf?

Dabei gehe davon aus das die HDD-Festplatte technisch & mechanisch

immer in einem guten Zustand ist.

Es geht mir dabei um HDD-Festplatten mit Lesekopf und Magnetscheiben, keine SSD's!

Ich habe seit dem Jahr 1999 meine Datensammlungen. Dabei bevorzuge

ich immer die Original-Kopie wenn möglich von der ältesten Erstellung.

Wenn ich meine Daten jetzt mit jeder neuen HDD immer weiter verschiebe,

wann treten erst Fehler auf? Theoretisch wenn es die 100.000ste Festplatten-KOPIE ist?

Ich habe jetzt seit 22jahren Dokumente & es gab mit Windows

keinen einzigen sichtbaren Fehler in der Dateistruktur. Videos, Musik & Dokumente immer tadellos.

Da war mal ein Bild-Dokument was oben noch intakt war, und dann nur noch graue Zeilen.

Ich hatte immer Glück und bei meinen Festplatten ist kein mechanischer Defekt aufgetreten.

Den Faktor einer mechanisch beschädigten Festplatte kann man vernachläßigen.

{{{ Da große Speichermengen für Archive immer wichtiger werden,

werden die Magnetscheiben bald durch Glas ersetzt. Heute sind 20TB in einer 3,5"-HDD

von Seagate bereits für den Massenmarkt verfügbar.

Mit der neuen Glastechnik sind dann Speichermengen mit 100TB normal. }}}

Grüßè und Dank

Datenträger - Festplatten, SSDs, Speichersticks und -Karten, CD/ 19.585 Themen, 110.173 Beiträge

In der aktuellen Form ist die Frage vielleicht etwas ungenau formuliert. Du wirst da keine pauschale Antwort geben können, sondern nur in Form einer Wahrscheinlichkeit. Wobei man da dann ggf. auch noch nach Spezifikation und Realität unterscheiden könnte.

Was man schon mal klar sagen kann: Es kommt auf die Größe an!

Bei der 2KB (2*10^3Byte) Textdatei ist das Risiko eines Bitfehlers wesentlich geringer als bei einer 200GB (2*10^11Byte) großen VM.

Für Festplatten geben die Hersteller im Datenblatt eine Fehlerrate an. Aktuell liegt die häufig in einer Größenordnung von einem nicht korrigierbaren Bitfehler bei 10^14 gelesenen Bit. Das ist grob eine Größenordnung von 10TB. Du musst aber tendenziell davon ausgehen, dass diese Angabe auch nur für eine typische Betriebsdauer gilt und bei einer 20 Jahre alten Festplatte höhere Fehlerraten hat als spezifiziert (und Festplatten in diesem Alte auch noch höhere Fehlerrate haben)

Zum Überblick: Kurz erklärt: Bitfehler bei Festplatten

Zur Vorbeugung kannst Du Checksummen über die Dateien Bildern um die Korrektheit zu prüfen. Wobei das u.U. auch nicht so leicht sein wird, weil die Dateiinhalte direkt nach dem Schreiben noch im Datenträgercache liegen.

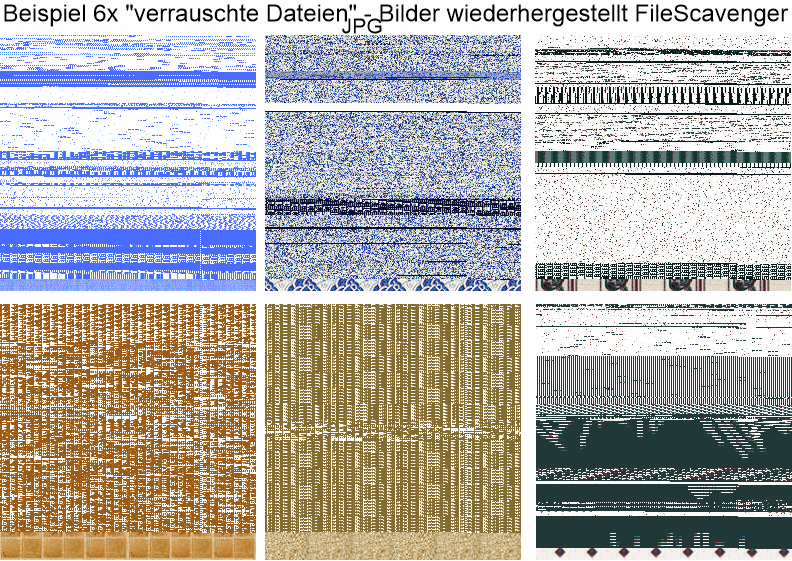

Beispiel Datei angehängt

Beispiel Datei angehängt

Sind das nun konkrete Beispiele von Dir? Die zeigen nun Beispiele wie ein Bild durch ein Bitfehler kaputt gehen kann. In wie weit das nun zu Fragestellung des Wanns beiträgt wird mir allerdings nicht klar.

Hallo ernstherz,

Die Frage ist, ob eine Datei bereits beim ersten Kopieren von einem Datenträger auf einen anderen noch unverändert ist. Bei einer Videodatei machen sich "Bit-Fehler" nicht unbedingt bemerkbar. Ich habe da vor längerer Zeit schon rumexperimentiert. Das hier beschriebene Prüfverfahren gilt auch heute noch: https://www.nickles.de/c/s/praxis-externe-festplatten-usb-datensaerge-enttarnen-623-1.html

Grüße,

Míke

ich habe eine praktische Frage:

wenn ich eine Datei 100.000mal bis millionen-fach kopiere (also immer KOPIEvonKOPIEvonKOPIE...)

Ich finde, dass das eine höchst theoretische Frage ist.

Hast Du wirklich in der Praxis mit solchen Vorgängen zu tun, bei denen 100.000mal eine Dateikopie von einer Dateikopie erstellt wird?

Was ist denn das für eine praktische Anwendung , bei der das passiert?

Ich finde, dass das eine höchst theoretische Frage ist.

Die Fragestellung gilt schon seit einigen Jahren als praxisrelevant. Wenn Du nach Spezifikation bei 10 mal Auslesen (u.U. auch weniger oder mehr, je nach Platte; Teilweise reicht schon 3 mal, wie z.B. bei einer WD40EZRZ) der kompletten Platte einen Fehler bekommst, dann sollte man das Thema nicht mehr einfach ignorieren…

Wenn Du nach Spezifikation bei 10 mal Auslesen (u.U. auch weniger oder mehr, je nach Platte; Teilweise reicht schon 3 mal, wie z.B. bei einer WD40EZRZ) der kompletten Platte einen Fehler bekommst, dann sollte man das Thema nicht mehr einfach ignorieren…

Beim kompletten Auslesen einer Platte kopiere ich aber nicht eine Datei 100.000mal, sondern vielleicht 100.000 Dateien einmal. Von den 100.000 Dateien ist dann nach 10mal Auslesen eine Datei defekt, 99.999 sind es jedoch nicht.

Aber wo wird denn eine Datei in der Praxis 100.000 mal kopiert?

Die 100.000 Kopiervorgänge waren Teil der Frage um eine Größenordnung zu definieren. Und bei sehr großen Dateien (In Datenträgergröße) könnten bereits 3 Kopiervorgänge ausreichen. Bei einer sehr kleinen Dateien (unter Sektorgröße) könnten es auch 300.000.000.000 Kopiervorgänge nötig werden.

Aber wo wird denn eine Datei in der Praxis 100.000 mal kopiert?

Würde ich noch am ehesten erwarten, wenn man z.B. für 100K User-Accounts eine Standard-Konfigurationsdatei kopiert.

Würde ich noch am ehesten erwarten, wenn man z.B. für 100K User-Accounts eine Standard-Konfigurationsdatei kopiert.

Das entspricht aber nicht der Fragestellung.

Bei Deinem Beispiel liegt die Original-Datei immer am selben Ort und von dieser Datei werden dann 100.000 Kopien gemacht.

A > A'

A > A''

A > A'''

usw.

Der TS hat aber ein (Praxis-??)Beispiel, wo die Abfolge so aussieht:

A > A' > A'' > A'''

usw.

Und das dann

100.000mal bis millionen-fach

Wo wird sowas in der Praxis gemacht?

Nach Aussage des Threadstarters nutzt er erst immer die erste Kopie als Basis. Damit wären nun nicht automatisch alle nachfolgenden Kopien einer fehlerhaften Kopie auch fehlerhaft.

Nach Aussage des Threadstarters nutzt er erst immer die erste Kopie als Basis.

Die Formulierung

also immer KOPIEvonKOPIEvonKOPIE.

wann treten dann erste Fehler auf?

bedeutet für mich, dass eben gerade nicht die erste Kopie immer die Basis jedes Kopiervorgangs ist sondern dass immer eine Kopie der (letzten) Kopie gemacht wird (usw.), die Fehler also immer kumuliert werden.

Deswegen kam mir das eher vor, wie ein theoretisches Beispiel und kein praktisches.

Letztendlich kann nur der TS erklären, was für Praxisbeispiel er mit seiner Praxisfrage nun konkret meint.

bedeutet für mich, dass eben gerade nicht die erste Kopie immer die Basis jedes Kopiervorgangs ist

Unsinn, er schreibt doch:

Dabei bevorzuge

ich immer die Original-Kopie wenn möglich von der ältesten Erstellung.

Noch präziser geht es doch kaum.

Noch präziser geht es doch kaum.

Das hatte aber nichts mit seiner zuerst gestellten Frage zu tun.

Oben schrieb er doch (sehr präzise):

ich habe eine praktische Frage: wenn ich eine Datei 100.000mal bis millionen-fach kopiere (also immer KOPIEvonKOPIEvonKOPIE...) wann treten dann erste Fehler auf?

Dass er selbst einen anderen Weg wählt, ändert doch nichts an seiner ursprünglichen Frage.

Das hatte aber nichts mit seiner zuerst gestellten Frage zu tun.

Das, ist eine rein hypothetische Frage, auf die Du (wie alle Anderen) keine Antwort hast, aber tausend Fragen.

Der TS hätte genau so gut fragen können:"Wann bekomme ich als geimpfter Corona?"

Diese Frage ist auch relevant, für viele, folglich gibt es darauf auch tausend Antworten. Nur keine präzise...

oben hatte ich gemeint:

wenn ich die Wahl habe: würde ich die ältere Kopie behalten und die neuere löschen. Wenn ich meine Daten auf eine größere Festplatte 'umziehen', lege ich immer die alte-kleinere Festplatte als BACKUP in den Schrank! Und verwende Personal Backup zum synchronisieren alle paar Monate.

Man bedenke, in Firmen gibt es Kunden-Datenbanken und unzählige TXT-Dateien, wenn da ein Zahlendreher auftritt, könnte das eine große Katastrophe sein.

würde ich die ältere Kopie behalten und die neuere löschen.

Ja, so hatte ich das verstanden.

Aber die Eingangsfrage ist von so vielen Faktoren abhängig, dass sie niemand beantworten kann, ohne zu spekulieren.

Für mich gibt es keine Datei, die so wichtig wäre, als dass sie nicht ersetzbar wäre.

und unzählige TXT-Dateien, wenn da ein Zahlendreher auftritt,

Ist die Mechanik längst abgeraucht...

würde ich die ältere Kopie behalten und die neuere löschen

Für eine zuverlässige Langzeitarchivierung müsste man es allerdings genau umgekehrt machen!

Die Wahrscheinlichkeit, dass man Daten auf dem (der immer weiter voranschreitenden Alterung unterliegendem) ursprünglichen Medium verliert, ist sicher viel größer als die der Kopierfehler beim wiederholten Kopieren von einem (älteren, aber noch intakten) Datenträger auf den nächsten (völlig neuen, unverschlissenen) Datenträger.

Also

A > A'

A > A''

A > A'''

führt sicher eher in die Katastrophe als

A > A' > A'' > A'''

Ich hatte mich nur gefragt, bei welcher Anwendung Du in der Praxis mit 100.000 oder sogar Mio solchen Vorgängen zu tun hast.

Wenn jemand sein ganzes Leben lang Daten sammelt und er alle zehn Jahre seinen kompletten Datenbestand von einer älteren auf die nächste neue Platte kopiert, sollte er doch selbst bei 100 Lebensjahren mit maximal 10 Kopiervorgängen hinkommen.

Die Wahrscheinlichkeit, dass man Daten auf dem (der immer weiter voranschreitenden Alterung unterliegendem) ursprünglichen Medium verliert, ist sicher viel größer als die der Kopierfehler beim wiederholten Kopieren von einem (älteren, aber noch intakten) Datenträger auf den nächsten (völlig neuen, unverschlissenen) Datenträger.

Also

A > A'

A > A''

A > A'''

führt sicher eher in die Katastrophe als

A > A' > A'' > A'''

Beim wiederholten Kopieren musst Du Dir aber bewusst sein, dass sich die das Fehlerrisiko kumuliert. Wenn Du 1% Fehlerrisiko (bei einer kleinen Datei wäre das extrem viel, aber wenn wir eine Sammlung von Dateien in der Größenordnung eines Datenträgervolumens betrachten, dann ist das vielleicht sogar schon optimistisch) hast, dann kannst Du in der Variante

A > A' > A'' > A'''

nach 100 Kopiervorgängen nur noch mit 37% wahrscheinlich ein fehlerfreies Endergebnis. Bei 10 Kopiervorgängen sind es auch nur noch 90%.

Da wäre es nun interessant wie sich die Fehlerrate von Festplatten über die Lebensdauer verändert.

Ich habe keinerlei empirische Daten zu diesem Thema und kann nicht realistisch abschätzen, nach wie vielen Kopiervorgängen eine bestimmte Datei (bzw. ein bestimmter Dateityp) hinreichend zerstört ist.

Fakt ist: Mit zunehmendem Alter wird es immer unwahrscheinlicher, Daten von einem alten Datenträger überhaupt noch auslesen zu können. (Beispiele dazu wurden hier immer wieder mal diskutiert.)

Es kann also nicht die Lösung sein, immer nur auf die ursprüngliche Datei (auf dem Ursprungsdatenträger) zurückzugreifen und immer wieder davon neue Kopien zu machen während man gleichzeitig die vorletzte, auf einem relativ jungen Datenträger vorhandene und definitiv noch intakte Datei wieder vernichtet.

Große Archivbestände werden ja gerade dadurch gesichert, dass die Daten immer wieder umkopiert werden.

Wenn es besser wäre, nach dreißig, vierzig oder fünfzig Jahren immer noch eine Kopie vom (30 / 40 / 50 Jahre) alten Datenträger zu machen, könnte man sich zwischendurch das regelmäßige Umkopieren (z.B.) alle 5 Jahre ja auch komplett sparen.

Wenn es um Langzeitarchivierung geht, wird man auch eher Magnetbänder und keine Festplatten einsetzen, wobei auch noch andere Probleme (z.B. die spätere Verfügbarkeit geeigneter Lesegeräte) zu berücksichtigen sind.

Am Ende sind zufällige Kopierfehler wahrscheinlich das kleinste Problem...

nach wie vielen Kopiervorgängen eine bestimmte Datei (bzw. ein bestimmter Dateityp) hinreichend zerstört ist.

Es gibt zwar Dateiformate bei denen ein Bitfehler nicht zwingend sofort katastrophale Auswirkungen hat, aber auch dort kommt es wieder drauf an welches Bit betroffen ist. Bei unkomprimierten Bilddaten wird das in vielen Fällen harmlos sein: Wenn der Fehler innerhalb der Bilddaten auftritt, dann hast Du da dann im schlimmsten Fall mal einen weinroten statt einem schwarzen Pixel. Bei Auftreten im Dateiheader kann der Dateityp nicht mehr erkannt werden, oder die Datei in Folge falscher Größenangaben nicht mehr gelesen. Bei einem MSO-XML-Format ist die Datei wahrscheinlich sofort unbrauchbar, da Zip-Kompression Bitfehler nicht so leicht verzeiht.

Große Archivbestände werden ja gerade dadurch gesichert, dass die Daten immer wieder umkopiert werden.

Wobei das Umkopieren dann auch immer mit einem verifizierendem Lesen verbunden sein sollte. Das verhindert zwar erst mal keine Fehler, aber stellt sicher dass die sofort erkannt werden. Bei MO-Datenträgern waren entsprechende Mechanismen sogar mal direkt in Hardware eingebaut: Die haben die geschriebenen Daten immer bei der nächsten Umdrehung noch mal zur Prüfung gelesen, was natürlich die Schreibgeschwindigkeit um 50% reduziert hat…

Wobei das Umkopieren dann auch immer mit einem verifizierendem Lesen verbunden sein sollte. Das verhindert zwar erst mal keine Fehler, aber stellt sicher dass die sofort erkannt werden. Bei MO-Datenträgern waren entsprechende Mechanismen sogar mal direkt in Hardware eingebaut: Die haben die geschriebenen Daten immer bei der nächsten Umdrehung noch mal zur Prüfung gelesen, was natürlich die Schreibgeschwindigkeit um 50% reduziert hat…

Die Schreibgeschwindigkeit ist nicht ganz unwichtig.

Ein Problem ist, dass die anfallende Datenmenge schneller wächst als die Bandbreite, die man zum Wegschreiben solcher Datenmengen brauchen würde. Der Datensammler erstickt förmlich in seinen mühsam zusammengetragenen Daten...

Man bedenke, in Firmen gibt es Kunden-Datenbanken und unzählige TXT-Dateien, wenn da ein Zahlendreher auftritt, könnte das eine große Katastrophe sein.

Da kannst Du dann aber weitere Maßnahmen ergreifen um die Risiken zu reduzieren:

- Dateisysteme mit Prüfsummen nutzen. Dann werden Fehler schneller sichtbar.

- ECC-RAM verwenden

- Transaktionsprotokolle schreiben

ich finde folgenden Beitrag von heise-Magazin total aussage-kräftig:

---"Kurz erklärt: Bitfehler bei Festplatten | iX | Heise Magazine" Neben der Spur geschrieben

---nickles-de "PRAXIS: Externe Festplatten - USB-Datensärge enttarnen"

in der Praxis mache ich von meinen 1x 5TB 4x 2TB 2x1TB hauptLaufwerken BACKUP's. Unter anderem mit einem 12TB+8TB Ziellaufwerk. Es gibt die Aussage eines Festplatten Herstellers: "man sollte am Tag nicht mehr als 500gb-Daten schreiben".

Zitat: "davon ausgehen, dass beim Lesen von rund 8 bis 12 TByte statistisch gesehen ein defekter Sektor enthalten ist"

Es kommt auch vor das der Schreib-Lesekopf falsch auftrifft:

siehe: "Neben der Spur geschrieben" - Zitat: passieren Fehler ab etwa 108 Positionierungen der Schreib-/Leseköpfe, unter Volllast laufenden Festplatte mit 4 ms Zugriffszeit einmal pro Woche passiert.

---Weitere Fehlerquellen:

der Cache der Festplatte,

deren Firmware,

das Datenkabel,

die Firmware des Controllers

und dessen Hardwaretreiber

{{108 =100.000.000x}}

Die Daten auf einer Daten-Kassette haben sich auch nach einigen Jahren selber ausgelöscht, weil die magnetischen Eisenband-Lagen sich gegenseitig auslöschten. "Es wird leiser und es tritt ein Rauschen auf". Es gab ein Start-Signal, das Programm konnte dann einen Datensatz schreiben oder lesen. Das lesen ging in meinem Fall nicht mehr. Das waren noch die Basic-Programmier & Turbo-Pascal 6.0 Zeiten.

Die Daten auf einer Daten-Kassette haben sich auch nach einigen Jahren selber ausgelöscht, weil die magnetischen Eisenband-Lagen sich gegenseitig auslöschten.

Damit sollte die Idee, immer von der ältesten Kopie einer Datei die nächste Kopie zu machen, nun wirklich ad acta gelegt werden.

---Weitere Fehlerquellen:

Arbeitsspeicher

Es gibt die Aussage eines Festplatten Herstellers: "man sollte am Tag nicht mehr als 500gb-Daten schreiben".

Auf welche Festplattengröße bezieht sich denn dieses Aussage?

Soll man sich zum Füllen einer 12TB-Platte 24 Tage Zeit lassen?

diese Aussage: 500gb/Tag, ist für größere Festplatten gedacht.

Hat vermutlich was mit einer längeren Haltbarkeit zu tun? Oder vermehrten Datenfehlern bei neuen Festplatten mit höheren Kapazitäten. Zitat:"enorme Anstieg der Plattenkapazitäten zu veränderten Fehlerraten führt" /&/ "neuen SMR-Festplatten – Shingled Magnetic Recording, wie Dachschindeln angeordnete Magnetpartikel, geht man von einem Fehler pro 1014 Bits aus =11,4TByte" (wurde bei der ersten Antwort schon genannt)

Mir ist noch aufgefallen, bei SSD Festplatten wird bei Crystal-Disk-Info immer die 'written GBytes' angegeben. Wenn ich jetzt z.B. 10gb kopiere entsteht der SSD eine vielfach Höhere 'written GB' Auslastung in real.

diese Aussage: 500gb/Tag, ist

eine Fehlinfo. Es gibt sogn. Workloads, die von den Herstellern angegeben werden, diese sind aber nicht bindend und beziehen sich auf den gesamten Lebenszyklus einer Festplatte und nicht darauf, ob man die HDD einmalig oder gelegentlich mal in einem Ruck vollknallt.

Hier eine Info von Seagate dazu: https://www.seagate.com/de/de/support/kb/annualized-workload-rate-005902en/

Wovon man eine Backup-Kopie anfertigt, hängt von der Datei und ihrer Verwendung ab. Die Fehlerrate beim Kopieren ist genauso akademisch wie die MTBF. Gegen sowas gibt es das Backup und fertig ist. Wer mehr daraus macht, ist falsch informiert oder hat eine Paranoia. ;-)